A Apple anunciou o lançamento do Apple Intelligence, sua nova plataforma de inteligência artificial, durante a WWDC 2024. A integração ocorrerá a partir do segundo semestre de 2024 e permitirá que iPhones, iPads e Macs utilizem recursos de escrita, edição de imagens e melhorias na assistente virtual Siri. Com essa novidade, a Apple se destaca em meio à concorrência no setor de tecnologia, buscando oferecer soluções inovadoras para o dia a dia dos usuários.

Além de funcionalidades como resumos automáticos e sugestões de mensagens, o Apple Intelligence permite a criação de emojis personalizados e ilustrações a partir de texto. A Siri também ficou mais inteligente, conseguindo realizar tarefas como editar imagens e responder contextualmente a comandos. Essas atualizações visam tornar as interações mais práticas e enriquecedoras para o usuário.

A Apple planeja expandir o suporte do Apple Intelligence para diversos idiomas até 2025, incluindo o português. Recursos adicionais, como a integração com o ChatGPT, serão oferecidos, além de uma plataforma para desenvolvedores que desejam implementar IA em seus aplicativos. O atraso na nova versão da Siri, prevista para 2026, visa garantir a qualidade e a precisão das interações com os usuários.

A Apple firmou sua posição no universo da inteligência artificial com o lançamento do Apple Intelligence, apresentado durante a WWDC 2024. A partir do segundo semestre de 2024, a tecnologia foi integrada aos iPhones, iPads e Macs, trazendo consigo novas ferramentas de escrita, edição de imagens e aprimoramentos para a assistente virtual Siri.

Essa iniciativa surge em meio a uma competição acirrada entre grandes empresas do setor, como Google, OpenAI e Anthropic, que buscam ampliar a presença de sistemas generativos em produtos voltados ao consumidor. A Apple se diferenciou ao optar por incorporar as funcionalidades de IA diretamente em seus aplicativos e sistemas operacionais, ao invés de apresentar serviços de forma isolada, como fazem alguns de seus concorrentes.

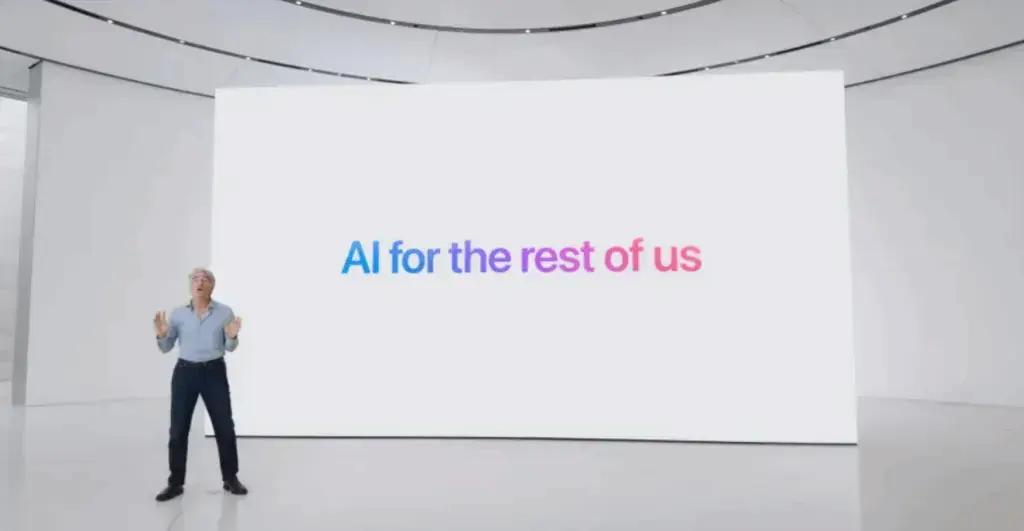

O Apple Intelligence é definido por executivos da empresa como “IA para o resto de nós”. A proposta é aplicar modelos de linguagem e geração de conteúdo nas tarefas do dia a dia, oferecendo suporte dentro dos aplicativos nativos. Os recursos variam desde resumos automáticos em e-mails e textos longos até sugestões de mensagens personalizadas em apps como Mail, Mensagens e Pages.

No sistema de geração de imagens, duas frentes se destacam. A primeira é a criação de emojis personalizados, chamados de Genmojis. A segunda é o Image Playground, um aplicativo independente que permite elaborar ilustrações a partir de comandos de texto, que podem ser integradas a apresentações, conversas ou redes sociais.

A Siri, que antes tinha interações limitadas, agora está mais integrada ao sistema operacional. Além de responder a comandos de voz, a assistente pode editar imagens, inserir conteúdo em mensagens e usar o contexto da tela para oferecer respostas relacionadas à atividade do usuário. A reformulação também inclui uma nova interface visual, com iluminação ao redor da tela durante o uso.

O lançamento do Apple Intelligence ocorreu com a atualização iOS 18.1, juntamente com o iPadOS 18.1 e o macOS Sequoia 15.1, em outubro do mesmo ano. A implementação inicial foi em inglês, nos Estados Unidos, e depois expandiu-se para os idiomas australiano, canadense, neozelandês, sul-africano e britânico. A previsão é que em 2025 o suporte se estenda para chinês, francês, alemão, italiano, japonês, coreano, português, espanhol, vietnamita e variações regionais do inglês.

A segunda fase de lançamento, com a atualização iOS 18.2, trouxe novidades como Genmoji, Image Playground, Image Wand e a integração com o ChatGPT. A expectativa é que recursos como Visual Intelligence, voltado para pesquisa visual, e Live Translation, para tradução em tempo real em aplicativos de comunicação, sejam lançados junto com o iOS 26, previsto para o final de 2025.

O acesso ao Apple Intelligence depende de processadores recentes. Entre os smartphones, apenas o iPhone 15 Pro e 15 Pro Max, com chip A17 Pro, e toda a linha iPhone 16 são compatíveis. Nos tablets, é necessário ter processadores M1 ou superiores nos modelos iPad Pro e iPad Air. O iPad mini passa a ser compatível a partir da versão equipada com A17. No segmento de computadores, o sistema funciona em MacBook Air, MacBook Pro, iMac, Mac mini e Mac Studio com chips da série M1 em diante. O Mac Pro exige o processador M2 Ultra.

Uma das características técnicas do Apple Intelligence é a capacidade de executar operações no próprio dispositivo. A Apple desenvolveu modelos reduzidos e especializados, capazes de realizar tarefas como a composição de e-mails sem a necessidade de conexão com a internet.

Para solicitações mais complexas, a Apple introduziu o Private Cloud Compute, um conjunto de servidores baseados em Apple Silicon. O objetivo é permitir o processamento remoto, mantendo o mesmo padrão de privacidade oferecido nos dispositivos pessoais. A escolha entre a operação local ou na nuvem ocorre automaticamente, sem que o usuário perceba a diferença, exceto em situações de falta de conexão.

A integração com o ChatGPT foi apresentada como complementar, permitindo que os usuários autorizem a Siri a recorrer ao ChatGPT em determinadas perguntas, como receitas ou planejamento de viagens. O recurso Compose amplia as ferramentas de escrita do Apple Intelligence, permitindo criar textos personalizados a partir de comandos. A integração é gratuita, mas os assinantes pagos do ChatGPT têm acesso a funções adicionais, como consultas ilimitadas. A Apple informou que pretende incluir parcerias com outros serviços, sendo o Google Gemini o próximo da lista.

Na WWDC 2025, a Apple revelou a estrutura Foundation Models, voltada para desenvolvedores interessados em criar recursos de inteligência artificial integrados a aplicativos de terceiros. Essa iniciativa possibilita utilizar os modelos locais do Apple Intelligence sem custos de API em nuvem, preservando a privacidade dos dados.

Apesar das mudanças anunciadas, a Apple adiou para 2026 uma versão mais avançada da Siri. A expectativa é que essa nova etapa inclua a compreensão do “contexto pessoal”, abrangendo relacionamentos, rotinas de comunicação e histórico de interações. Segundo Craig Federighi, vice-presidente sênior de engenharia de software da Apple, o atraso está relacionado à necessidade de atingir padrões internos de qualidade.

Via Startupi